Топ самых больших ошибок, совершённых нейросетями

Эйфорию и неописуемый восторг от возможностей нейросетей мы наблюдаем почти каждый день в наших новостных лентах. «Искусственный интеллект научился определять ложь» или «ИИ научился измерять давление по голосу» – заголовки цепляют и внушают мысль, что будущее уже показывает носы своих парадных туфель из-за угла. Но за всем этим великолепием теряются новости про крупные неудачи нейросетей. И хорошо, если ошибки в их работе не принесут вреда человеку или компаниям, но как правило этого избежать не удаётся. В этой статье собраны 3 самых громких провала искусственного интеллекта, повлёкшие за собой падение репутации и доходов пользователей.

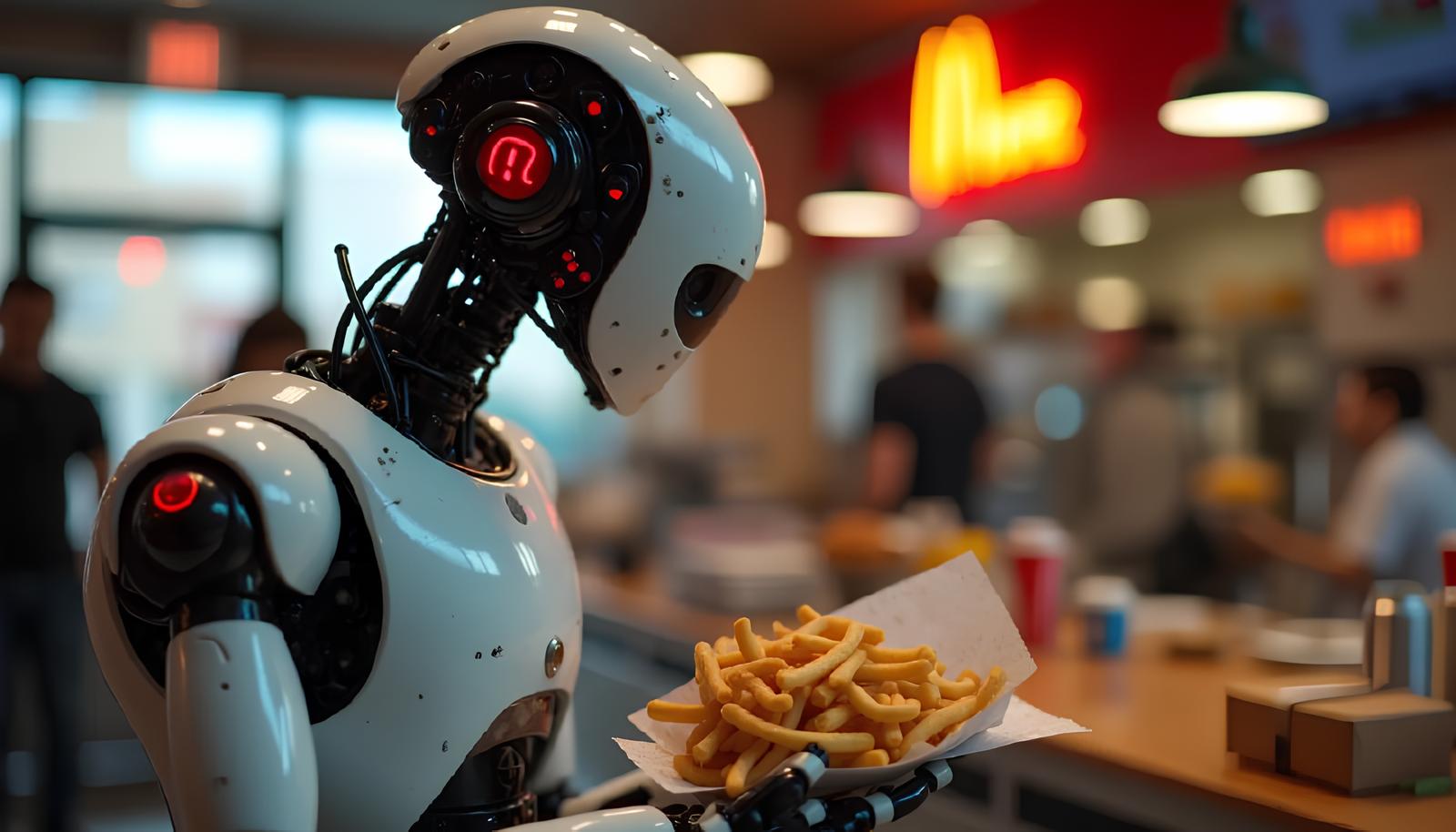

Свободная касса или как ИИ не стал кассиром в Mcdonald’s

В 2021 году самая известная в мире фастфуд-сеть решила внедрить искусственный интеллект в свои заведения. Работа нейронки заключалась в приёме заказов на вынос. Вроде бы всё просто, но диалог с клиентами не заладился.

В соцсетях стало появляться много роликов растерянных клиентов, которые пытаются заставить ИИ понять их заказы. Однажды 2 молодых человека просто захотели поесть макнаггетсов. Но не смогли остановить нейросеть, которая посчитала, что парни настолько голодны, поэтому закинула в корзину аж 260 штук! Не, ну продажи эта штука точно подняла бы.

Пока идею голосовых заказов в McDonald’s отложили в сторону. Но полностью отказаться от затеи не планируют.

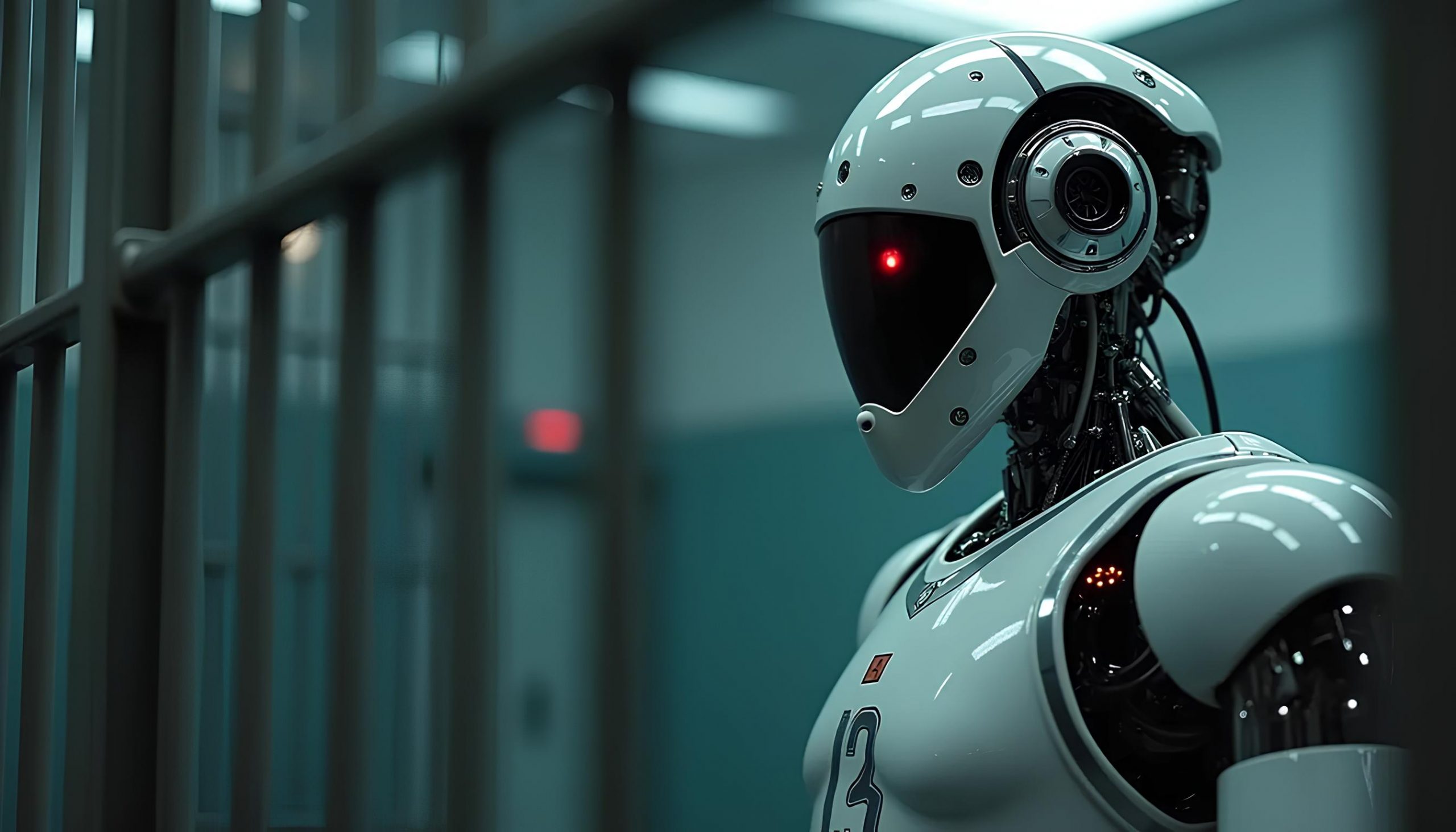

ВандалИИзм: как чуть не сесть в тюрьму из-за искусственного интеллекта

Звезду НБА Клэя Томпсона в апреле 2024 года обвинили в том, что он бросал кирпичи в окна домов в Сакраменто. Такое серьёзное высказывание сделал не человек, а Grok – чат-бот на основе искусственного интеллекта, разработанный компанией xAI.

Баскетбольные знатоки сразу раскусили здесь что-то нечистое. Дело в том, что неудачные броски в этом виде спорта принято называть «бросанием кирпичей». У Томпсона ранее была игра, в которой он показал своё худшее выступление в постсезоне. Соответственно об этом было много новостей с использованием той самой профессиональной терминологии. Grok начитался этой информации и почему-то решил объединить её с новостью о вандализме в калифорнийском городке.

О чём это говорит? Что проверять достоверность фактов искусственным интеллектом до сих пор необходимо. Не всегда он способен выстраивать причинно-следственные связи между полярно разными новостями. Ну и остаётся открытым вопрос, кто несёт ответственность за такие грубые ошибки ИИ?

Хотел помочь, а получилось как всегда

Пассажира авиакомпании Air Canada в особенно трудный для него момент искусственный интеллект решил добить своей ложью.

Бедолага Джейк Моффатт обратился за помощью к виртуальному ассистенту авиакомпании Air Canada, чтобы узнать о льготах для пассажиров, потерявших близких. Ранее в этом году он потерял свою бабушку. Чат-бот предложил ему приобрести билеты по стандартным тарифам из Ванкувера в Торонто и подать заявку на компенсацию в течение 90 дней после покупки. Так Моффат и поступил. Но когда он попытался вернуть деньги, авиакомпания отклонила его запрос, пояснив, что льготы для пассажиров, потерявших близких, не предоставляются после покупки билетов.

Далее была жалоба в суд за халатность авиакомпании, исказившей информацию через своего виртуального помощника. Air Canada утверждала, что не может нести ответственности за информацию, предоставленную её чат-ботом. Но суд встал на сторону пострадавшего и ему выплатили обещанную компенсацию вместе с возмещением морального ущерба.

Фото: сгенерированы нейросетью Flux

1

1

0

0

0

0

0

0

0

0